ユーザ ガイド > 表情をアニメートする >

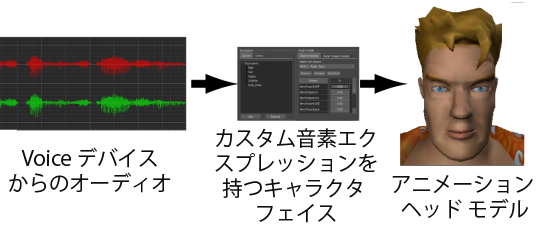

キャラクタ フェースと Voice デバイスを使用すると、声を表すオーディオ ファイルや生のオーディオ入力に合わせてキャラクタが「話す」様子をセット アップできます。Voice デバイスを通じて、オーディオ入力の音素がキャラクタの表情を動かします。

オーディオドリブン フェーシャル アニメーション ワークフロー

ヘッド モデルの形状は、オーディオ入力に合わせてキャラクタが伝える音素の数に適した形状である必要があります。また、Voice デバイスのサウンド パラメータに合致している必要もあります。「音素シェイプ」も参照してください。

追加のサウンド パラメータ(音素音)を Voice デバイスに追加すると、カスタム エクスプレッションが自動的に Expressions ペインに表示されます。